La caverna de Platón y las alucinaciones de la IA

En uno de los libros de La República el filósofo griego Platón describe una alegoría con el objetivo de explicar las diferencias entre el "mundo sensible" y el "mundo inteligible". En este texto se describe a un grupo de hombres esclavizados que viven dentro de una caverna con formaciones caprichosas cuyo conocimiento sobre el mundo exterior está condicionado por las sombras que se proyectan dentro de esta caverna.

Recientemente los modelos neuronales tanto del lenguaje como para la generación de imágenes de la inteligencia artificial, podrían parecernos un mundo de conocimiento distante al que nosotros logramos comprender fuera de nuestra expertise. Yo por ejemplo me declaro incapaz de detectar a simple vista una de las llamadas alucinaciones de los modelos del lenguaje natural por ejemplo en la nanotecnología o en la biomedicina. No me avergonzaría decir que el acceso a ChatGPT por ejemplo me hace un esclavo dentro de una caverna.

Existen distintos puntos de vista que sugieren las razones por las cuales un modelo como ChatGPT podría generar alucinaciones y comprender correctamente las matemáticas detrás de estos errores está increíblemente lejos de ser entendido.

Alucinaciones y la maldición de la dimensión

La maldición de la dimensión es una expresión simplista para explicar fenómenos geométricos o estadísticos que no podemos entender correctamente cuando buscamos dibujar estos fenómenos en dimensión dos o tres que es donde la mayor parte de nosotros podemos imaginar con soltura.

Siguiendo con la alegoría de Platón, podríamos imaginar al mundo sensible como un espacio de dos o tres dimensiones y al mundo inteligible como la complicada geometría que ocurre en cientos o miles de dimensiones. Uno de los enunciados matemáticos que mejor resume este fenómeno es el siguiente:

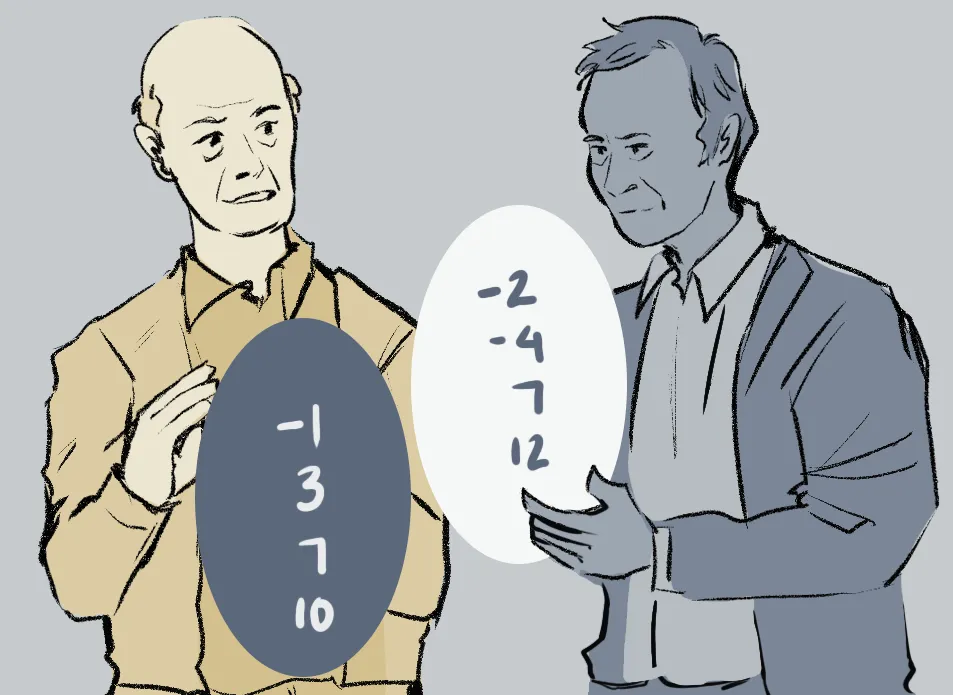

- Si elegimos al azar dos puntos X y X' en un espacio de dimensión d lo suficientemente grande, el 95% de las veces estarán a una distancia prácticamente idéntica

Si consideramos que los modelos generativos se entrenan con una función de pérdida muy similar a la del cálculo de la distancia entre ellos, esto significa que la distancia entre la respuesta correcta a un prompt y una alucinación es en general bastante pequeña. Las hipótesis son consistentes pues las representaciones de nuestros textos viven en amplias dimensiones.

Dicho lo anterior, es notable cómo las redes neuronales no son víctimas de la maldición de la dimensión en más ocasiones y las alucinaciones son vistas como fenómenos extremos.

Para comprender mejor los estudios que se han hecho sobre este tema les recomiendo leer el artículo The Relationship Between High-Dimensional Geometry and Adversarial Examples.

¿Alucinaciones o descubrimiento?

En la alegoría de la caverna, se sugiere que el conocimiento del que se están perdiendo los esclavos no es ficticio, sino que pertenece verdaderamente a descubrimientos de los que se están perdiendo los esclavos por solo comprender algunas sombras.

Lo anterior nos hace preguntarnos si eventualmente los humanos podríamos percibir como alucinaciones algún descubrimiento que estén haciendo los modelos de redes neuronales profundas.

Un artículo que sugiere algo parecido es el titulado Adversarial Examples Are Not Bugs, They Are Features, en el cual se experimenta con inputs aparentemente adversariales que en realidad son el reflejo de variables latentes con un alto poder explicativo, pensemos por ejemplo en patrones dentro de imágenes que no podemos observar a simple vista.

Oferta académica

- Track de Ciencia de Datos. (49 semanas).

- Machine Learning & AI for the Working Analyst ( 12 semanas).

- Matemáticas para Ciencia de Datos ( 24 semanas).

- Especialización en Deep Learning. (12 semanas).

- Track de Finanzas Cuantitativas (49 semanas)

- Aplicaciones Financieras De Machine Learning E IA ( 12 semanas).

- Las matemáticas de los mercados financieros (24 semanas).

- Deep Learning for Finance (12 semanas).