MA2301 - Matemáticas para la Ciencia de Datos

.png)

Semana

1

.png)

Bien entendidas, las bases de datos con las que se entrenan los modelos en Machine Learning son el resultado de un proceso aleatorio el cual puede modelarse con distintos tipos de distribuciones.

MA2301 - Feb 6, 2023

MA2301 - Feb 8, 2023

MA2301- Feb 10, 2023

Semana

2

La correlación es una medida estadística que utiliza la frecuencia con la que dos variables se relacionan proporcionalmente con la misma constante. Pensemos por ejemplo en el número de metros cuadrados y el costo de un terreno.

MA2301- Feb 13, 2023

MA2301- Feb 15, 2023

MA2301 - Feb 17, 2023

Semana

3

La primera vez que se propuso utilizar una distribución de Poisson fue para calcular la frecuencia con la que se encarcelaba injustamente en Francia, tomando en cuenta el número de sentencias.

MA2301 - Feb 20, 2023

MA2301 - Feb 22, 2023

MA2301 - Feb 24, 2023

Semana

4

La Ley de los Grandes números es uno de los únicos resultados matemáticos que garantiza que una base de datos podría ser una buena aproximación a un resultado general, pensemos por ejemplo en un sondeo previo a una elección presidencial.

MA2301 - Feb 27, 2023

MA2301 - Mar 1, 2023

MA2301 - Mar 3, 2023

Semana

5

Gracias al comportamiento límite de las cadenas de markov es posible predecir cuáles serían las páginas más visitadas si navegamos aleatoriamente por aquellas páginas que contengan un texto.

MA2301 - Mar 8, 2023

MA2301 - Mar 9, 2023

MA2301 - Mar 10, 2023

Semana

6

Utilizando el algoritmo de metropolis Hastings es posible descifrar mensajes codigicados por medio de una búsqueda aleatoria a través de todas las posibles traducciones.

MA2301 - Mar 13, 2023

MA2301 - Mar 15, 2023

MA2301 - Mar 17, 2023

MA2301 - Mar 20, 2023

MA2301 - Mar 22, 2023

MA2301 - Mar 24, 2023

Semana

8

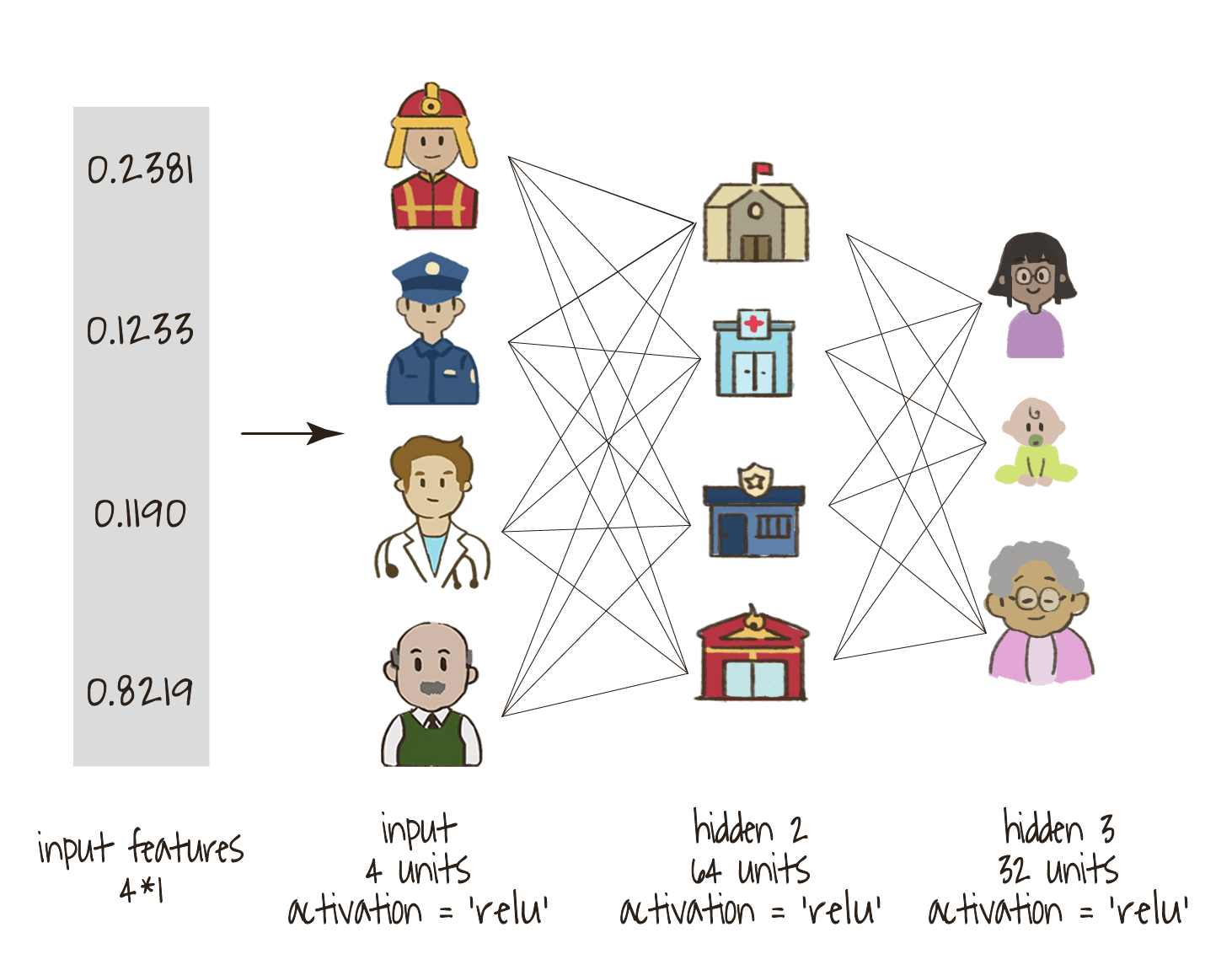

El aprendizaje supervisado es muy parecido al problema de resolver un sistema de ecuaciones lineales, en este caso las matrices formadas por la base de datos es muy similar a la de los coeficientes en un sistema de ecuaciones lineales.

MA2301 - Mar 27, 2023

MA2301 - Mar 29, 2023

MA2301 - Mar 31, 2023

Semana

9

Así como la correlación nos permite calcular las relaciones que existen entre dos columnas, es posible detectar cuando dos registros dentro de nuestra base de datos son semejantes por medio del ángulo entre nuestros vectores.

MA2301 - Apr 10, 2023

MA2301 - Apr 12, 2023

MA2301 - Apr 14, 2023

Semana

10

Una de las técnicas de compresión más conocidas es el análsiis de componentes principales el cual construye una aproximación lineal de nuestra información mediante una cantidad menor de coordenadas. Podemos pensar en la información genética de las personas.

MA2301 - Apr 17, 2023

MA2301 - Apr 19, 2023

MA2301 - Apr 21, 2023

Semana

11

Las bases de datos con una enorme cantidad de textos son muy complicadas desde el punto de vista computacional y gracias a la factorización de matrices es posible eficientar este tipo de búsquedas.

MA2301 - Apr 25, 2023

MA2301 - Apr 26, 2023

MA2301 - Apr 28, 2023

Semana

12

El concepto de auto-vector es un reflejo de las simetrías contenidas en algunas de nuestras bases de datos y en algunas ocasiones podemos utilizarlas para reducir la cantidad de cálculos.

MA2301 - May 1, 2023

MA2301 - May 4 , 2023

MA2301 - May 5 , 2023

Semana

13

Existen técnicas del álgebra lineal que permiten reducir el número de cálculos necesarios para realizar una búsqueda, este tipo de problemas son muy comunes en Big Data y utilizan métodos de reducción de la dimensión.

No items found.

MA2301 - May 15 , 2023

MA2301 - May 17 , 2023

MA2301 - May 19 , 2023

Semana

15

En algunas ocasiones nuestras bases de datos podrían no ser suficientemente grande para realizar una estimación con algún grado de confianza, en estos casos los tests estadísticos nos permiten medir con cierto grado de certeza la viabilidad de una hipótesis sobre la población total.

MA2301 - May 23 , 2023

MA2301 - May 24 , 2023

MA2301 - May 26 , 2023

Semana

16

La inferencia bayesiana nos permite añadir hipótesis que nosotros creemos y no necesariamente están siendo observados en nuestros datos, esto nos ayuda a reducir la varianza en nuestras estimaciones, estas técnicas son muy similares a las de la regularización en machine learning.

MA2301 - May 30 , 2023

MA2301 - May 31, 2023

MA2301 - Jun 2, 2023

Semana

17

Este es un problema típico de los bandidos multi-brazos en el que aparece el dilema de la exploración y la explotación, es decir en donde existe un trade-off entre obtener más observacioens y optimizar las decisioens con base en las que se han hecho.

MA2301 - Jun 6, 2023

MA2301 - Jun 7, 2023

MA2301 - Jun 9, 2023

Semana

18

Regresión bayesiana geolocalizada

La localización geográfica en la que se encuentren nuestros datos puede ser utilizada para mejorar la calidad de nuestras predicciones y por ello es importante conocer los métodos de machine learning geolocalizados.

MA2301 - Jun 13, 2023

MA2301 - Jun 16, 2023

Semana

19

Tradicionalmente las regresiones frecuentistas harán una hipótesis estática sobre los parámetros de un modelo, sin embargo en inferencia bayesiana es posible agregar priors sobre el conjunto total de los parámtros sobre los que estamos entrenando.

MA2301 - Jun 20, 2023

MA2301 - Jun 21, 2023

MA2301 - Jun 23, 2023

Semana

20

.png)

Por medio de los modelos causales introducidos por primera vezo por Judea Pearl, las computadoras pueden razonar mejor utilizando incertidumbre estadística, estos modelos además permiten el estudio causal de nuestros fenómenos.

MA2301 - Jun 30, 2023

MA2301 - Jul 4, 2023

MA2301 - Jul 5, 2023

MA2301 - Jul 7, 2023

Semana

22

Aunque parezca una técnica poco sofisticada, la programación lineal es una de las herramientas más versátiles para resolver problemas de matemáticas aplicadas, es cierto que las soluciones no resuelven todos los problemas sin embargo una amplia cantidad de problemas se pueden resolver por medio de estas técnicas.

MA2301 - Jul 11, 2023

MA2301 - Jul 12, 2023

MA2301 - Jul 14, 2023

Semana

23

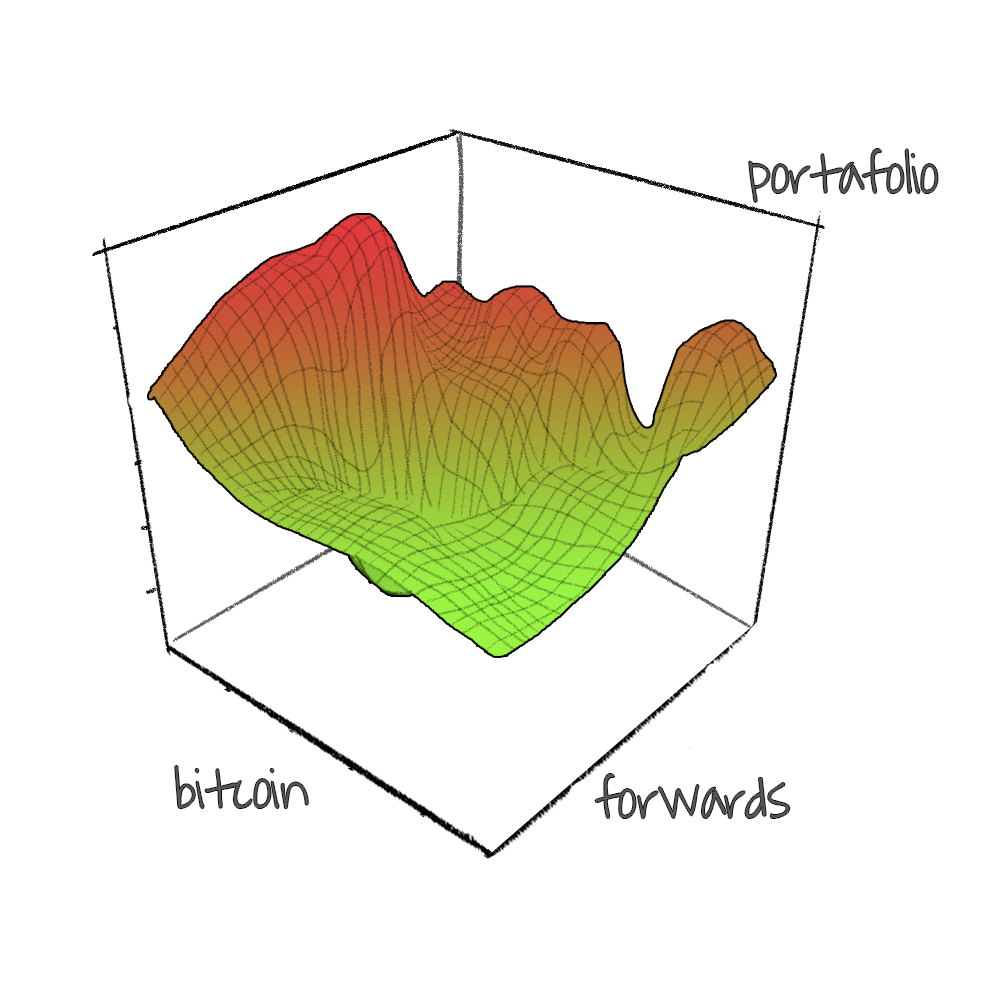

Las redes neuronales profundas son uno de los modelos matemáticos más utilizados y el método de aprendizaje que normalmente se utiliza fue propuesto por Cauchy, la idea principal es optimizar siguiendo la dirección opuesta del gradiente.

MA2301 - Jul 18, 2023

MA2301 - Jul 19, 2023

MA2301 - Jul 21, 2023

Semana

24

Aunque no existe una explicación matemática satisfactoria de por qué funcionan los modelos de machine learning, utilizando el concepto de convexidad ayuda a entender algunos casos particulaes en los que sí existen teoremas de convergencia.

MA2301 - Jul 26, 2023

MA2301 - Jul 27, 2023

MA2301 - Jul 28, 2023

Semana

El algoritmo del gradiente descendiente sería inviable para entrenar a las redes neuronales con billones de parámetros y por ello fue necesario un algoritmo extra que permita que su entrenamiento sea viable. Este algoritmo se conoce como Back-Propagation y fue propuesto por Hinton a finales de los 90's.

MA2301 - Aug 2, 2023

MA2301 - Aug 3, 2023

Semana

26

Cuando el entrenamiento de cada una de las redes neuronales profundas definida por un hiper-parámetro distinto es muy tardado, es posible utilizar optimización bayesiana que mejore la velocidad.

MA2301 - Aug 8, 2023

MA2301 - Aug 10, 2023

Semana

27

MA2301 - Aug 14,2023

WA2601 - 20 Feb, 2026

WA2601 - 19 Feb, 2026

EDL2601 - 19 Feb, 2026

NLP2601 - 19 Feb, 2026

MMF2601 - 19 Feb, 2026

WA2601 - 18 Feb, 2026

EDL2601 - 18 Feb, 2026

NLP2601 - 17 Feb, 2026

WA2601 - 17 Feb, 2026

EDL2601 - 17 Feb, 2026

MMF2601 - 16 Feb, 2026

EDL2601 - 16 Feb, 2026

NLP2601 - 12 Feb, 2026

M&DL2501 - 12 Feb, 2026

NLP2601 - 11 Feb, 2026

M&DL2501 - 10 Feb, 2026

NLP2601 - 09 Feb, 2026

M&DL2501 - 05 Feb, 2026

NLP2601 - 05 Feb, 2026

WA2504 - 04 Feb, 2026

NLP2601 - 04 Feb, 2026

WA2504 - 03 Feb, 2026

AF2503 - 03 Feb, 2026

M&DL2501 - 03 Feb, 2026

WA2504 - 29 Ene, 2026

NLP2601 - 29 Ene, 2026

AF2503 - 28 Ene, 2026

WA2504 - 27 Ene, 2026

NLP2601 - 27 Ene, 2026

AF2503 - 27 Ene, 2026

M&DL2501 - 27 Ene, 2026

M&DL2501 - 26 Ene, 2026

NLP2601 - 26 Ene, 2026

AF2503 - 26 Ene, 2026

AF2503 - 23 Ene, 2026

WA2504 - 23 Ene, 2026

NLP2601 - 22 Ene, 2026

M&DL2501 - 22 Ene, 2026

WA2504 - 20 Ene, 2026

AF2503 - 22 Ene, 2026

WA2504 - 22 Ene, 2026

WA2504 - 21 Ene, 2026

AF2503 - 21 Ene, 2026

NLP2601 - 20 Ene, 2026

AF2503 - 20 Ene, 2026

NLP2601 - 19 Ene, 2026

M&DL2501 - 20 Ene, 2026

M&DL2501 - 19 Ene, 2026

AF2503 - 19 Ene, 2026

AF2503 - 16 Ene, 2026

WA2504 - 16 Ene, 2026

NLP2601 - 15 Ene, 2026 (Parte II)

NLP2601 - 15 Ene, 2026 (Parte I)

WA2504 - 15 Ene, 2026

AF2503 - 15 Ene, 2026

WA2504 - 14 Ene, 2026

AF2503 - 14 Ene, 2026

M&DL2501 - 13 Ene, 2026

NLP2601 - 13 Ene, 2026

WA2504 - 13 Ene, 2026

AF2503 - 13 Ene, 2026

M&DL2501 - 12 Ene, 2026

AF2503 - 12 Ene, 2026

NLP2601 - 12 Ene, 2026

WA2504 - 09 Ene, 2026 / Parte II

WA2504 - 09 Ene, 2026 / Parte I

WA2504 - 06 Ene, 2026

AF2503 - 09 Ene, 2026

M&DL2501 - 08 Ene, 2026

WA2504 - 08 Ene, 2026

AF2503 - 08 Ene, 2026

AF2503 - 07 Ene, 2026

WA2504 - 07 Ene, 2026

NLP2601 - 06 Ene, 2026

AF2503 - 06 Ene, 2026

M&DL2501 - 06 Ene, 2026

NLP2601 - 05 Ene, 2026

M&DL2501 - 06 Ene, 2026

AF2503 - 05 Ene, 2026

AF2503 - 22 Dic, 2025

M&DL2501 - 18 Dic, 2025

WA2504 - 16 Dic, 2025

AF2503 - 17 Dic, 2025

AF2503 - 16 Dic, 2025

M&DL2501 - 16 Dic, 2025

WA2504 - 12 Dic, 2025

M&DL2501 - 15 Dic, 2025

AF2503 - 15 Dic, 2025

AF2503 - 12 Dic, 2025

M&DL2501 - 09 Dic, 2025

AF2503 - 11 Dic, 2025

M&DL2501 - 11 Dic, 2025

WA2504 - 10 Dic, 2025

AF2503 - 09 Dic, 2025

WA2504 - 09 Dic, 2025

M&DL2501 - 08 Dic, 2025

WA2504 - 04 Dic, 2025

AF2503 - 08 Dic, 2025

WA2504 - 05 Dic, 2025

WA2504 - 03 Dic, 2025